Полноформатный урок по нейросетям: основы и современные тренды

Что такое нейросети и зачем они нужны

Нейросети — компьютерные модели, вдохновленные мозгом, способные решать сложные задачи: классификация, генерация текста и изображений, управление роботами. Они являются фундаментом современного искусственного интеллекта, лежащим в основе поисковиков, ассистентов и генеративных систем.

Архитектура и базовые элементы нейросетей

Искусственный нейрон и персептрон

Нейрон обрабатывает входные данные, умножая их на веса и применяя функцию активации, аналогично взвешенному голосованию. Персептрон — простейшая нейросеть, способная решать линейно разделимые задачи. Многослойный персептрон (MLP) расширяет возможности, давая модели способность учить сложные зависимости.

Функции активации

Функции, создающие нелинейность в сети — такие как ReLU — позволяют модели обрабатывать сложные паттерны, формируя эффективные признаки.

| Тип функции активации | Описание | Плюсы | Минусы |

|---|---|---|---|

| Sigmoid | Выход от 0 до 1 | Интерпретируемый | Затухающие градиенты |

| Tanh | Выход от -1 до 1 | Центрированность | Затухающие градиенты |

| ReLU | (max(0, x)) | Быстрая сходимость | Мёртвые нейроны |

Алгоритмы обучения и обратное распространение

Обучение нейросети — процесс минимизации ошибки через градиентный спуск и обратное распространение ошибки. Итеративно корректируются веса для улучшения качества предсказаний.

Проблемы переобучения и способы регуляризации

Переобучение — когда модель слишком заучивает тренировочные данные и плохо работает на новых. Для борьбы используют Dropout, L1/L2 регуляризацию, аугментации и др.

Классификация типов обучения

| Тип обучения | Описание | Примеры применения |

|---|---|---|

| Supervisied | Обучение на размеченных данных | Классификация, распознавание речи |

| Unsupervised | Обучение без меток, поиск структуры | Кластеризация, генерация данных |

| Reinforcement | Обучение через взаимодействие и награды | Игры, управление роботами |

Основные архитектуры нейросетей

Полносвязные сети (MLP)

Подходят для табличных данных, но плохо масштабируются для изображений и сигналов.

Сверточные нейросети (CNN)

Выделяют локальные признаки в изображениях с помощью свёрток.

Рекуррентные сети (RNN, LSTM)

Обрабатывают последовательности с учётом контекста по времени.

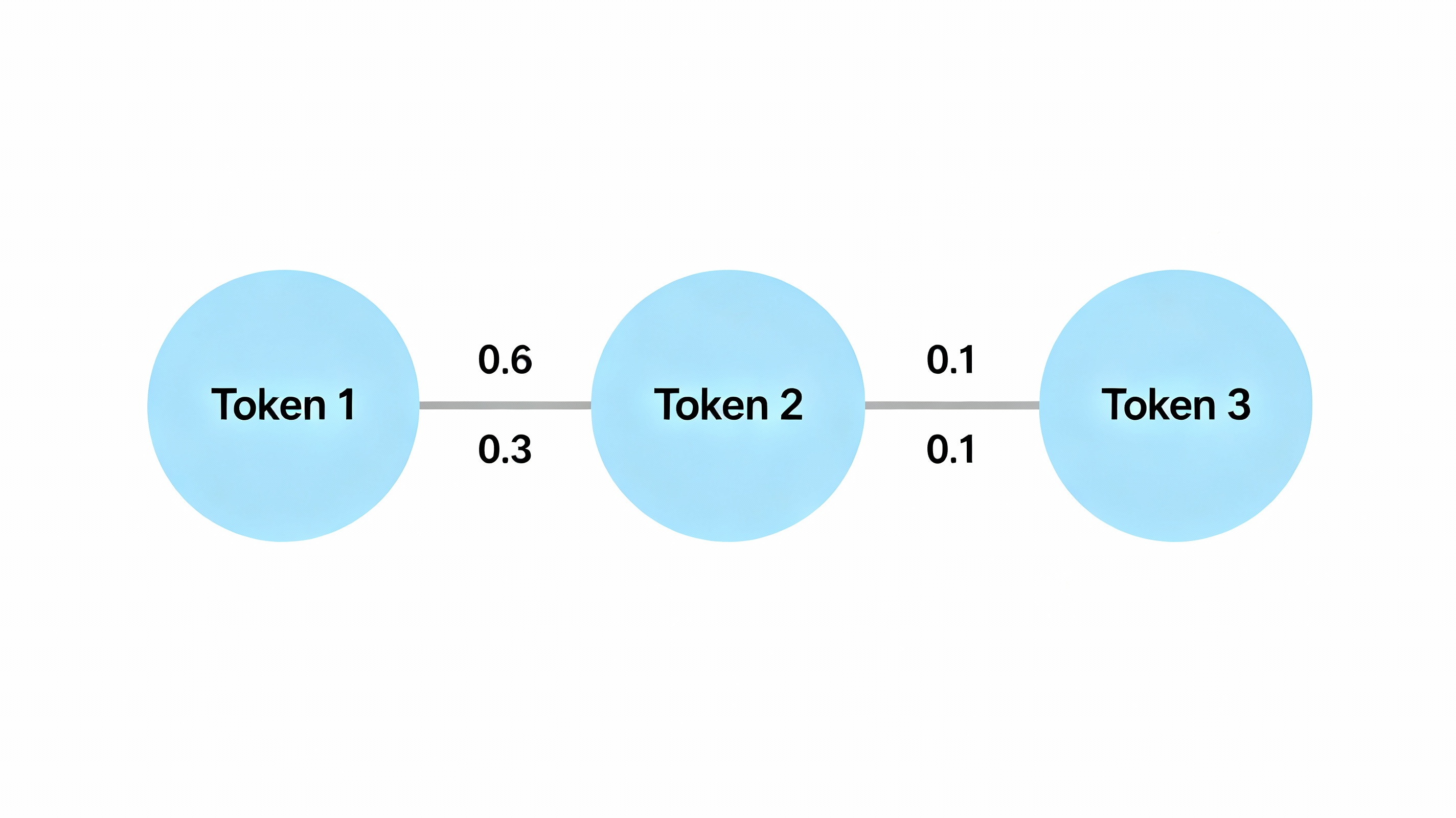

Трансформеры и механизм внимания (Attention)

Позволяют эффективно обрабатывать длинные последовательности параллельно.

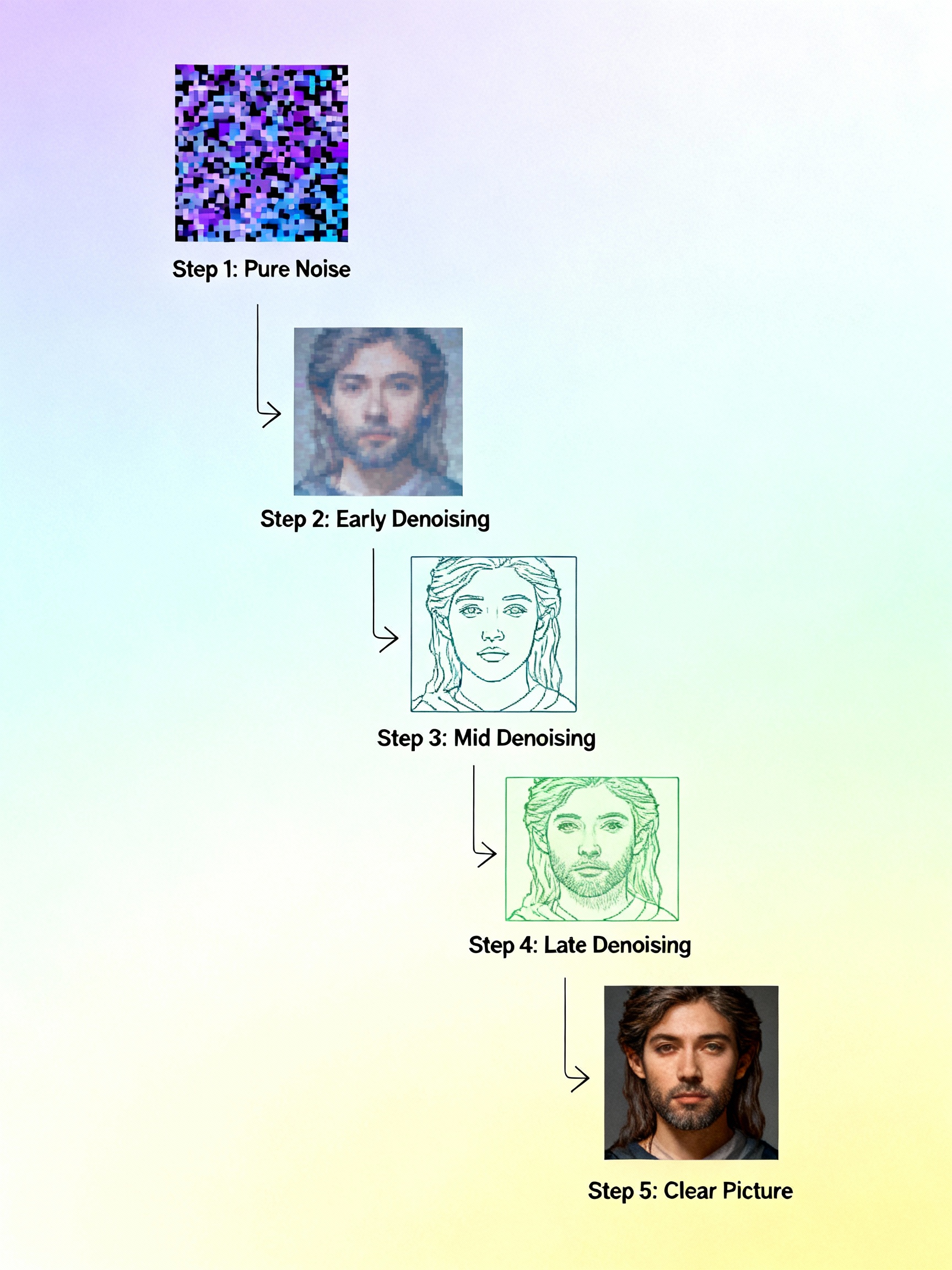

Диффузионные модели и генерация изображений

Принцип: поэтапное добавление и удаление шума для создания новых изображений.

Современные тренды 2024–2025 годов

- Мультимодальность: интеграция текста, изображений, видео и звука

- Открытые весы и локальное развёртывание моделей

- Оптимизация и аппаратное ускорение

- Востребованность комплексных специалистов

Практический блок: как начать

- Изучить Python, PyTorch/TensorFlow

- Работать с Jupyter-ноутбуками

- Попробовать простой пайплайн: загрузка, модель, обучение, проверка

- Экспериментировать с открытыми наборами данных и примерами

Минимальный псевдокод обучения нейросети

Загрузка и подготовка данных

train_data, val_data = load_and_preprocess()

Создание модели

model = NeuralNetwork(layers=[Input(), Hidden(ReLU), Output(Softmax)])

Определение функции потерь и оптимизатора

loss_fn = CrossEntropy() optimizer = Adam(model.parameters())

Обучение

for epoch in range(num_epochs): for x, y in train_data: preds = model(x) loss = loss_fn(preds, y) loss.backward() optimizer.step() optimizer.zero_grad() validate(model, val_data)

Заключение

Понимание нейросетей даёт конкурентное преимущество и доступ к современным ИИ технологиям. Учитесь полноцикловой разработке: от идеи и построения модели до внедрения в продукт и улучшения по результатам.

← Назад к списку уроков